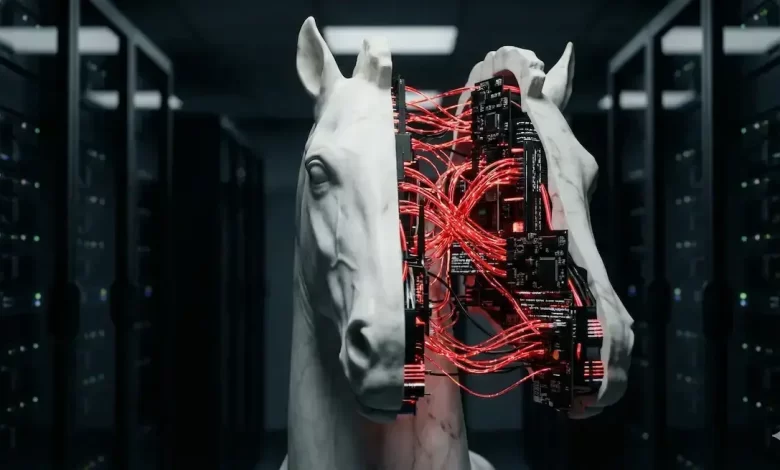

O Inimigo Silencioso

Algoritmos de Tróia: o risco invisível na cadeia de suprimentos de IA. Por Jeremias Goedert

Existe um velho ditado militar que diz: “Amadores falam de estratégia, profissionais falam de logística”. No mundo da Inteligência Artificial, precisamos atualizar essa frase para: “Amadores falam de prompt, profissionais falam de cadeia de suprimentos”.

Enquanto discutimos exaustivamente sobre alucinações do ChatGPT ou o risco de substituição de empregos, uma ameaça muito mais perigosa está se formando nos bastidores, invisível até para a maioria dos CTOs: os Algoritmos de Tróia (Trojan AI).

Diferente de um malware tradicional que quebra a porta da frente, um Algoritmo de Tróia é um modelo que aparenta normalidade sob testes usuais. Ele passa nos testes de qualidade, entrega respostas precisas e ajuda seu time a codar mais rápido. Mas ele carrega um gatilho oculto (um backdoor). Pode ser uma palavra específica, uma sequência de pixels em uma imagem ou uma data futura. Quando esse gatilho é acionado, o “agente adormecido” desperta e executa uma ordem maliciosa: exfiltrar dados, alterar um resultado financeiro ou desligar um sistema de segurança.

Em tempos de Clawdbot > Moltbot > OpenClaw, o risco explodiu com a popularização dos Agentes Autônomos e do Open Source. Hoje, desenvolvedores baixam modelos pré-treinados de repositórios públicos (como o Hugging Face) da mesma forma que baixam bibliotecas de código, muitas vezes sem qualquer verificação de segurança. Estamos importando “caixas pretas” para dentro do coração da empresa, assumindo que, se o modelo responde bem, ele é seguro.

Isso cria um cenário de pesadelo para a governança: a Vulnerabilidade da Cadeia de Suprimentos de IA. Se você usa um modelo que foi “envenenado” (data poisoning) na origem, não importa quão forte é o seu firewall; o atacante já está dentro da sala de comando.

Como se proteger de um inimigo que você convidou para entrar?

A resposta não é parar de usar modelos externos, mas aplicar o conceito de AI-BOM (AI Bill of Materials). Assim como a indústria exige a lista de ingredientes de um alimento, a governança deve exigir a rastreabilidade dos modelos de IA. Precisamos saber: Com quais dados esse modelo foi treinado? Quem o auditou? Existe assinatura criptográfica garantindo que ele não foi alterado desde o treinamento?

Em vez de confiar apenas em “Defesa de Perímetro”, é essencial complementar com “Defesa de Comportamento” em tempo de execução: estabelecer sandboxes para agentes e ferramentas com listas de permissão, quotas e rate limits, aplicar princípios de privilégio mínimo e segregação de funções para todo o tool use, codificar políticas de acesso e de egress (policy-as-code) com DLP específico para LLM/embeddings e monitorar continuamente padrões de atividade com detecção de anomalias comportamentais.

Na prática, qualquer desvio do escopo esperado — por exemplo, um assistente de código tentando consultar bases de produção sem justificativa — deve acionar bloqueio automático, registro em trilha de auditoria, alerta a SecOps e, quando aplicável, rollback de versão do modelo ou isolamento do agente, preservando integridade e disponibilidade sem paralisar o negócio.

Sem governança de proveniência e monitoração contínua, a confiança cega em artefatos de IA será uma das principais superfícies de ataque corporativas. A inovação exige velocidade, mas a sobrevivência exige desconfiança. Adote a IA, mas verifique a “bagagem” que ela traz antes de deixá-la entrar na sua fortaleza.